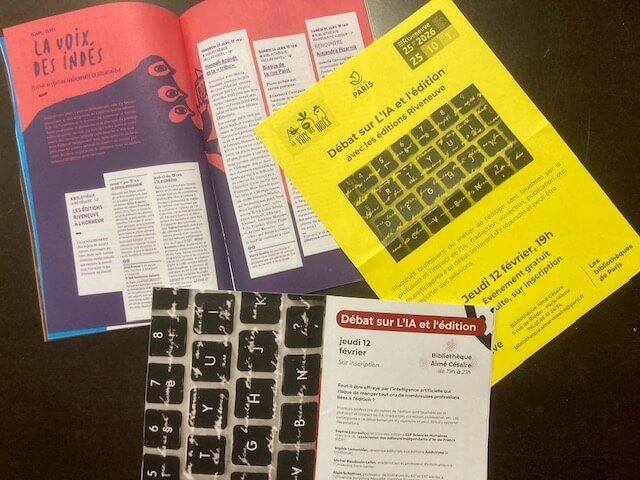

Dans le cadre du festival « La voix des indés », la bibliothèque Aimé Césaire (Paris 14e) a reçu, jeudi 12 février, une cinquantaine de personnes pour échanger autour d’un thème quasi obsessionnel aujourd’hui : l’impact de l’IA appliquée au monde des livres et de l’édition. « Faut-il être effrayé par l’intelligence artificielle qui risque de manger tout cru de nombreuses professions liées à l’édition ? » s’interroge la revue EnVue des bibliothèques parisiennes.

L’académicien et professeur d’informatique Michel Baudouin-Lafon, le professeur de lettres à l’université de la Sorbonne Nouvelle Alain Schaffner et les éditeurs indépendants Sophie Courault (éditions ESF Sciences Humaines et Magenta) et Gilles Kraemer (Riveneuve) ont rapporté les enseignements tirés de la journée professionnelle spéciale IA du premier salon du livre de l’édition indépendante en Île-de-France « Lisons Libres ! » de septembre dernier, auquel ils avaient tous participé au nom de l’EDIF (l’association des éditeurs) ou d’ICCARE (le programme de recherche associant la recherche en sciences numériques, sciences sociales et humaines et industries culturelles et créatives).

Si les résultats de l’IA appliquée à la rédaction d’argumentaires, à la synthèse de manuscrits ou à leur traduction restent bluffants au premier abord, ils se révèlent décevants à y regarder de plus près : erreurs, inventions, banalités, absences… On dirait un « mauvais stagiaire paresseux », mais qui met déjà pas mal de monde au chômage, notamment chez les traducteurs (Harlequin, maison d’édition culte de la romance populaire du groupe américain HarperCollins, vient d’arrêter net sa collaboration avec des dizaines de traducteurs et traductrices en décidant de tout traduire par IA pour casser ses coûts) ou les illustrateurs.

Déjà, plus de 40 % de ce qui circule sur Internet est généré par des IA qui ne s’entraînent pas que sur des textes humains plus ou moins pillés (des sociétés d’auteurs et d’éditeurs attaquent en justice aux États-Unis, en Europe ou ailleurs…), mais aussi sur des textes eux-mêmes générés par IA, entraînant de plus en plus « d’hallucinations », ces erreurs et inventions inexpliquées.

Au total, l’académicien a pu affirmer que, contrairement à ce qu’assurent les concepteurs qui prétendent que cela va en s’améliorant, les grands modèles de langage qui avaient toujours plus de données sont condamnés à se dégrader. L’avenir serait plutôt du côté de moteurs d’IA spécialisés, s’appuyant sur des sources fiables et centrés sur des secteurs de niche.

Dans l’édition, l’usage doit rester maîtrisé et, comme en a témoigné la directrice de Magenta, réservé à faciliter le quotidien, comme l’échange par la traduction en langue inconnue avec des éditeurs étrangers, par exemple, mais sans remplacer l’humain dans l’écriture, la traduction, la correction, l’illustration ou l’indication des métadonnées sur les livres, comme cela est systématiquement précisé sur ses ouvrages « faits par des humains » ou dans les contrats de ses auteurs.

On aura appris quelques néologismes dans la soirée : « sycophancif » (caractère de l’IA qui reste toujours flatteuse), « agentique » (prochaine génération des IA après la « générative », qui agit à notre place en commandant et payant nos services) ou « humaniseur » (IA qui retravaille les textes générés par IA pour leur donner un aspect « plus humain »). Le meilleur des mondes ?